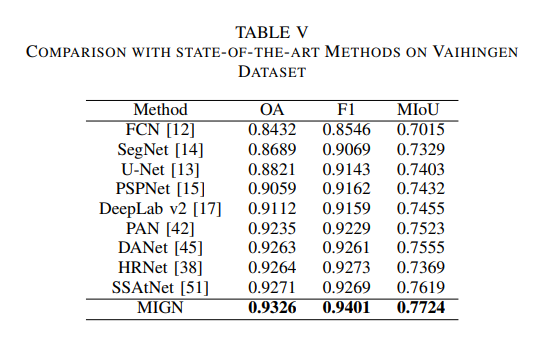

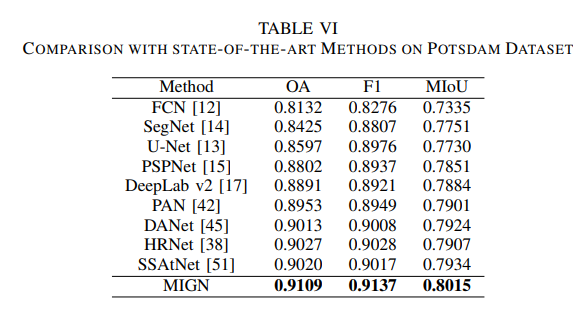

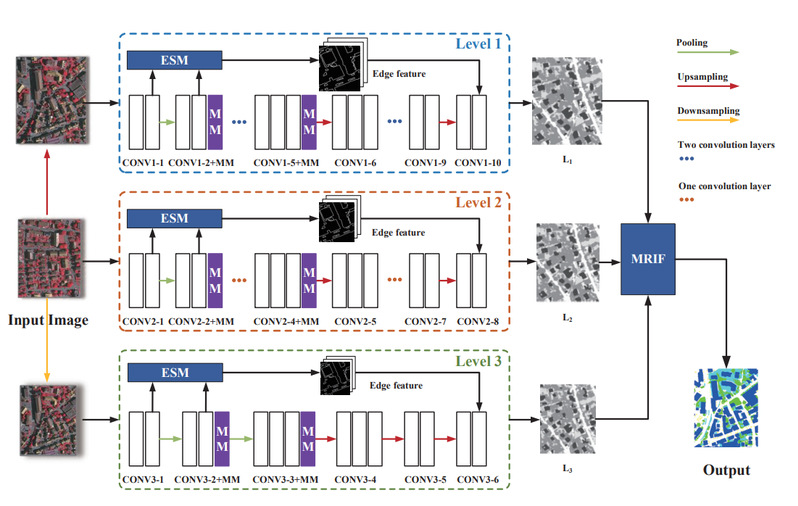

随着计算机视觉的发展,遥感图像的语义分割已经成为一个重要的课题,并被应用于城市规划、自然灾害监测、土地资源管理等各种应用中来进行图像内容分析和理解。人们提出了许多方法来解决这些问题。然而,由于遥感图像与普通图像在分辨率、空间结构和语义等方面存在明显差异,遥感图像的语义分割仍然具有挑战性。在本文中,我们提出了一种用于遥感图像语义分割的多尺度图像生成网络(MIGN),它可以同时考虑细节和边界信息,有效地生成高分辨率的分割结果,并且特别设计了一种用于遥感图像语义分割的多注意力机制方法。在两个分支结构中,通过捕获交叉维度的相互作用来计算注意力权重,从而学习底层特征信息,保证每个像素特征在最终分类时的性能。我们还提出了边缘监督模块,以确保分割边界具有更准确的性能。为了提高分割模块的精度,提出了一种基于Bayes模型的多尺度图像融合算法。我们的模型在ISPRS Vaihingen和Potsdam数据集上进行了性能评估。结果表明,该方法在MIoU和像素精度方面优于目前最先进的图像分割方法。

本文提出了一种新的遥感图像多尺度语义分割模型。该模型能充分考虑全局信息和局部信息。并提出了三个有效的模块来提供更精确的分割图像。首先,多注意力模块的作用是通过捕获两个分支的跨维度交互来学习更多的潜在信息。其次,边缘监督模块使不同类别之间的分割边界更加准确。最后,基于Bayes公式的多分辨率图像融合模块对不同尺度的图像进行融合,提高了模型分割精度。我们的模型在Vaihingen和Potsdam数据集上进行了性能评估。实验结果证明了该方法的有效性。